En la revista científica ‘Information Research: an electronic international journal‘ hemos dedicado un número especial a los 30 años de la puesta en marcha de la misma por parte de nuestro querido maestro Tom Wilson de la Universidad de Sheffield (y de la de Borâs en los últimos años). Para nosotros ha sido un honor haber participado en este número y casi en los treinta años de vida de esta revista gracias a la generosidad de su fundador.

En nuestra aportación, que reproducimos en versión HTML a continuación, destacamos los vínculos que se han establecido entre nuestra Universidad, la revista y Tom, además de resaltar que esta revista es acceso abierto antes incluso de que se acuñara ese término y se difudiera tras el acuerdo de la Iniciativa por el Acceso Abierto firmada en Budapest en el año 2002. Sin duda alguna, Tom es un maestro, un genio y mejor persona.

Texto del artículo:

Son muchos los méritos contraídos por Tom Wilson a lo largo de toda su carrera docente e investigadora, en la que ha venido introduciéndonos en el estudio de la gestión de información y del comportamiento informacional en contexto prácticamente desde el inicio de estas disciplinas. En ambos casos, se produce el mismo fenómeno: con el paso del tiempo, ambas forman un binomio de muy difícil separación, por no decir indivisible, tal como dijo José Vicente Rodríguez Muñoz la mañana en la que le investimos Doctor Honoris Causa por nuestra Universidad (septiembre de 201). Es posible que, con anterioridad a Tom Wilson, otros autores pudieran haber realizado aproximaciones parciales alrededor de estos conceptos, pero quien, con su esfuerzo, dedicación y sabiduría, muchas veces acompañado de un grandísimo equipo de colaboradores, ha permitido su desarrollo e implantación dentro de la comunidad científica como temas de interés.

De gran parte de todo ese trabajo ha sido testigo y depositaria la revista ‘Information Research: an electronic international journal‘, cuyo trigésimo aniversario celebramos con este número especial. Tal como informa la sección ‘About the Journal’ de su sitio web, fue fundada en 1995 por Tom Wilson en la Universidad de Sheffield y la ha dirigido casi todo este tiempo. En la presentación de la revista se comenta que ‘the Internet and the World ide Web were in their infancy, and the idea was to create a journal that covered the information disciplines in general’, recordando los significativos cambios acaecidos en nuestro campo durante todo este período, de proporciones exponenciales (casi hipergeométricas) en comparación con otros períodos anteriores donde la evolución seguía ritmos mucho más pausados.

La vocación internacional de la revista se observa claramente en el título de esta y constituye uno de sus puntos fuertes. No cabe duda alguna que esto es fiel reflejo de otro aspecto destacado de la personalidad de Tom Wilson: su afán por visitar la mayor parte de países del mundo posible para entrar en contacto con colegas y estudiantes. Gracias a esa actitud abierta y colaborativa tuvimos ocasión de conocerle personalmente y, desde entonces, ha sido para nosotros ese faro que guía a los barcos en la noche hacia puerto seguro donde descansar y avituallarse. Su primera visita a Murcia fue por motivo de un seminario sobre ‘Information Management’ justo el mismo curso que iniciábamos los estudios de Biblioteconomía y Documentación (1989-1999). Desde entonces, el contacto ha sido permanente y el vínculo se fue fortaleciendo hasta el punto de que es la única persona a quien se le ha concedido el Doctorado Honoris Causa a propuesta de nuestra facultad. Hicimos coincidir la ceremonia de investidura con esta distinción académica con la celebración de la conferencia ISIC-2010 para que una parte importante de sus amigos pudiera percibir en primera persona el alto nivel de reconocimiento y devoción que sentimos en esta humilde universidad del sureste de España por nuestro amigo, casi familia, Tom Wilson.

Durante este período de tiempo, el profesor Wilson participó como ponente invitado en el seminario de puesta en marcha de la Cátedra UNESCO en Gestión de Información en las Organizaciones, proyecto que coordinamos en colaboración con la Universidad de La Habana y que tuvo lugar en la Facultad de Economía de la Universidad Nacional Autónoma de México en el año 1995, unos meses antes de la puesta en marcha de la Maestría Internacional en Gestión de Información de la que llevamos realizadas más de 25 ediciones en distintos países de Latinoamérica y que ha permitido a muchos docentes e investigadores acceder al doctorado y progresar en su carrera académica.

En relación con ese progreso de la carrera académica y volviendo a la revista, no recordamos con precisión exacta la fecha, seguro que prácticamente en sus comienzos, el profesor Wilson abrió la posibilidad de publicar artículos en los idiomas portugués y español para colaborar en la difusión de los estudios e investigaciones realizadas en el ámbito iberoamericano, encargando en ese momento la responsabilidad de editar esa sección al profesor José Vicente Rodríguez Muñoz, nuestro maestro y compañero. Este hecho resultó fundamental para la comunicación de nuestras investigaciones en un ámbito internacional al que nos introdujo Tom Wilson, no sólo a los miembros de nuestra universidad, sino a muchos colegas de España, Portugal e Iberoamérica que aprovecharon ese espacio que gentilmente nos abrió el profesor Wilson. En el caso particular de nuestro departamento, Information Research ha sido depositaria de la buena parte de los artículos derivados de las tesis doctorales que hemos realizado a lo largo de estos 30 años, algunos de ellos con una considerable atención e interés por parte de la comunidad investigadora.

Hoy en día esa sección sigue recibiendo de forma periódica abundantes peticiones de publicación de artículos, si bien la tendencia actual es presentarlos en inglés (la lingua franca de la Ciencia). Podemos asegurar, sin temor a equivocarnos, que tanto la revista como su director, tienen una pequeña parte de culpa en esa internacionalización de la comunicación de la ciencia en nuestro entorno.

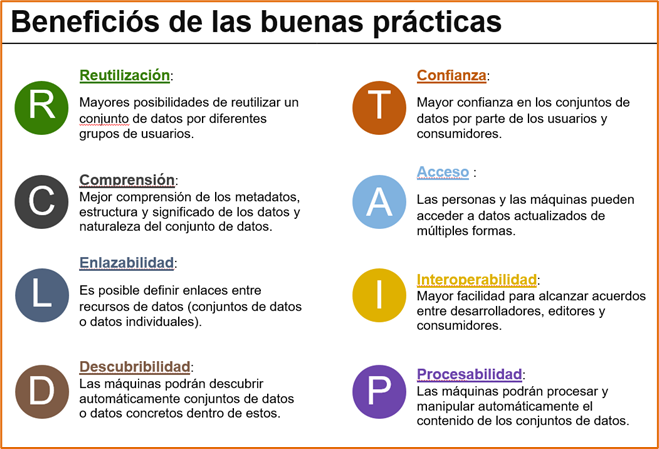

Information Research ha sido siempre una revista digital con el mismo nivel de gestión editorial que otras revistas de más longevas en el tiempo y con mayor presupuesto (algo imaginario en nuestro caso particular). Todo ha sido posible por la disposición de una multitud de compañeros y colegas que nunca han dudado a responder afirmativamente a la “llamada” de Tom Wilson para colaborar con la revista. En todos estos años hemos aprendido muchas cosas y queremos resaltar algunas de ellas. La primera fue la inmensa sorpresa que percibimos ante el nivel de dedicación y atención que investigadores y autores de referencia mundial prestaban a las tareas de revisión y edición de los artículos dentro de un contexto colaborativo impregnado de armonía, equidad y respeto por las decisiones adoptadas por todos los compañeros participantes. Esto nos ha servido a muchos de nosotros para replicarlo en otros proyectos editoriales en los que participamos, aprendiendo todos de todos. Otro aspecto que destacar es la formalidad del proceso editorial, al que muchos autores no estábamos acostumbrados en nuestros entornos locales en aquella época. El uso de una plantilla XHTML para la maquetación rigurosa de los artículos ha permitido además una mayor interoperabilidad y difusión de los textos dentro del ecosistema de la Web Semántica, también embrionario e incipiente cuando se implantó su uso. Continuando con los aspectos formales, la revisión de estilo, que se mantiene en la actualidad, es otra de las fortalezas de nuestra revista, a pesar de que se ha ido trivializando en otras revistas con el paso del tiempo.

Quizá los lectores más antiguos de esta revista recuerden que, al poco de haber sido indexada por la base de datos Social Science Citation Index (hoy parte de la WOS), hubo que introducir algunos cambios en la denominación de los artículos y guardar una copia de este y de las referencias empleadas en un sistema de archivo digital (webcitation.org) para intentar obviar la futilidad propia del ecosistema de la web de aquella época. Tom Wilson condujo inteligentemente este proceso y llevó a cabo la asignación de identificaciones permanentes de artículos para favorecer una preservación de los documentos cuando prácticamente esos conceptos eran embrionarios. Hace un par de años realizamos un sondeo para verificar la existencia de “citas perdidas” de los artículos de nuestra revista en la Web of Science (WOS), un problema presente en muchas publicaciones de acceso abierto y que añade otra tarea más sus comités editoriales. Cuál fue nuestra sorpresa, en realidad no tanto, cuando verificamos que Information Research tenía debidamente computadas todas. La rigurosidad editorial por bandera forma parte de nuestro genoma vital.

En los relativo a la indexación en bases de datos y la posición de la revista en los índices de impacto (estos últimos no han preocupado en exceso a Tom Wilson), la revista siempre ha estado recopilada por los principales productores y distribuidores, además de tener factor de impacto tanto en JCR/JCI como en el índice SJR donde nuestra publicación recibe más citas debido al mayor alcance geográfico del mismo, volviendo a poner de manifiesto que la internacionalización de la revista es una de nuestras fortalezas.

Lo que no ha cambiado nunca es el acceso abierto a los contenidos publicados en nuestra revista sin aplicar coste alguno a los autores de los artículos (las tan controvertidas como perniciosas APCs). Nuestra revista es, desde sus inicios, una revista de acceso abierto “diamante”. Y he aquí la paradoja, Information Research es acceso abierto cuando aún no se había redactado la Declaración de Budapest (2002); incluso Information Research es “diamante” cuando aún no se había tenido que establecer esta categoría de publicaciones para distinguir el verdadero acceso abierto del que pretenden instaurar las editoriales comerciales intenta hacer frente al acoso de las editoriales comerciales, financiadas con dinero público por culpa de una deficiente aplicación del Plan “S” que ha dado pábulo a la proliferación de revistas predadoras y/o de escaso nivel científico que dañan mucho a la comunicación de la ciencia. IR es un claro ejemplo de lo contrario, de cómo el sueño de Tom Wilson se ha consolidado en una publicación de referencia internacional, abierta a todo tipo de autores, consolidados y noveles, y a todas las disciplinas relacionadas con la investigación en información. Por todo ello, creemos de justicia afirmar que, tanto la revista como su impulsor y director hasta el año pasado, son “pioneros del acceso abierto” junto a todos quienes hemos dedicado una parte de nuestro tiempo a la misma.

Autores

Jose-Vicente Rodriguez-Munoz, Francisco-Javier Martinez-Mendez, Pedro-Manuel Diaz-Ortuno, Gregorio Moya-Martinez y Rosana Lopez-Carreno, miembros del Grupo de Investigación en Tecnologías de la Información de la Universidad de Murcia y colaboradores habituales con la revista en los últimos 30 años.

References

Budapest Open Access Initiative. (2002). https://doi.org/10.4403/jlis.it-8629

Fuchs, C., & Sandoval, M. (2013). The diamond model of open access publishing: Why policy makers, scholars, universities, libraries, labour unions and the publishing world need to take non-commercial, non-profit open access serious. TripleC: Communication, capitalism & critique, 11(2), 428-443. https://doi.org/10.31269/vol11iss2pp428-443

Rodríguez Muñoz, J.V. et al. (2010) Discursos pronunciados en el acto de investidura del profesor Thomas Daniel Wilson como Doctor Honoris Causa por la Universidad de Murcia. http://hdl.handle.net/10201/40450

cOAlition S. (2019). Accelerating the transition to full and immediate Open Access to scientific publications. Science Europe. https://archive.org/details/plan-s-rationale-310519

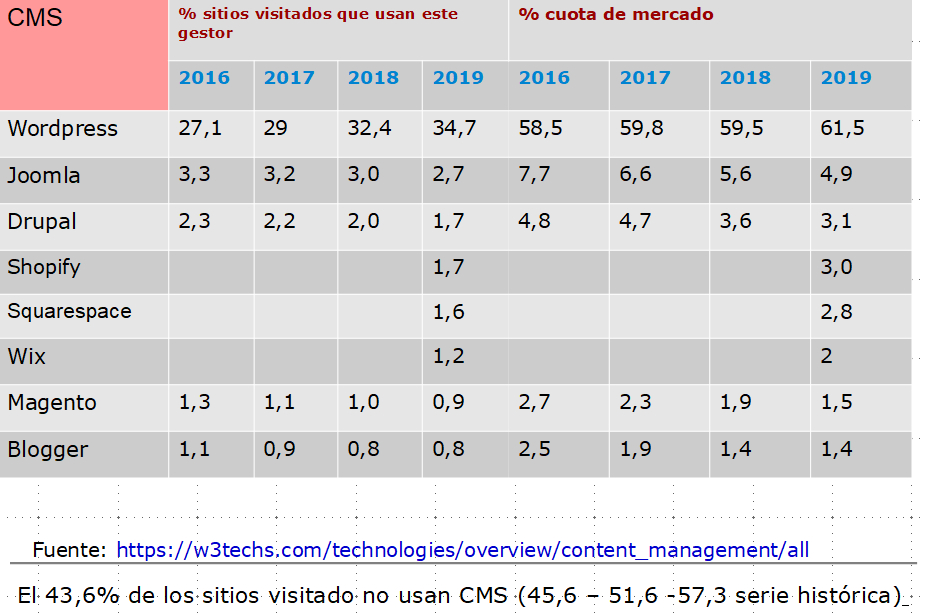

En 2019 publiqué la primera versión de este ‘post’ en el que recogía la tabla con datos estadísticos que les muestro curso a curso a mis estudiantes de la asignatura «Construcción de Servicios de Información Digital» (4º curso del

En 2019 publiqué la primera versión de este ‘post’ en el que recogía la tabla con datos estadísticos que les muestro curso a curso a mis estudiantes de la asignatura «Construcción de Servicios de Información Digital» (4º curso del